从A/B测试的角度分析多元测试

笔者遇到的另一个问题是如何把多元测试(一个对照对比多个变量)表达成两个分别的A/B测试。笔者认为这是可能的,因为两者的对照完全一致,且多元测试和两个连续的测试有着相同的样本大小和转换率。有一篇博客文章完整描述了其中一个测试的整个实验,结果表明,不单单是一个多元测试,还有未被提及的其他变量。因为在多元测试中,为了反映对照是和多个变量进行测试,我们需要调整p值和置信区间。这里便出现了问题,因为我们不能简单地进行成对的t检定或z检定,就像GoodUI中对一个个变量和对照进行p值计算。

p值和信赖区间的有效性所导致的后果和无从发现的数据窥探的后果相似︰相较报告中名义上的可能性,实际观察结果的可能性会更高。由于笔者并不知道在每一个A/B测试中有多少个变量,所以不能够对结果和最小可检测效应的计算进行Dunnett修正。笔者知道其中两个测试(#16和#17)的变量数目和它们的效应大小大于40%,暗示着它们有未解释的自选停止情况,故笔者决定把这两个测试移除。

笔者决定保留余下的测试,因为它们大部分在有着1至2个额外变量的假设下,仍然适当地保持了检定力。

A/B测试的元分析结果

115个测试的元分析结果明显有一部分测试(80=69.57%)欠缺统计检定力,有着或多或少严重的方法论问题。其中,有27个测试因明显妥协性测试而被移除。3个测试有着对照组和实验组在人流分配上的显著不平衡,故为了避免使用因技术上的可能问题而导致的偏差数据,这3个测试也被移除。16个测试是8个多元测试分拆的结果,即使如此,我们仍决定有能力能合理地评估它们的误差控制,它们当中的2个被移除,余下的则继续用作分析(有争议的决定)。

在移除3个不平衡随机化的测试和27个因缺乏固定样本大小和无从发现的数据窥探,导致统计上明显妥协的测试后,能进入元分析的测试有85个。(初始有115个)。

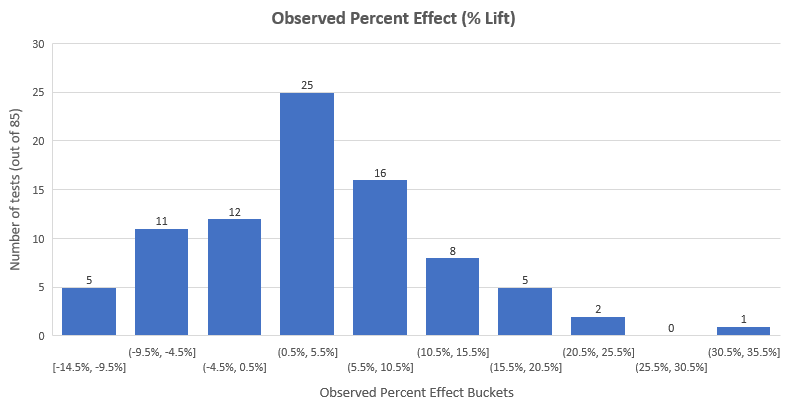

85个测试的平均百分比提升是3.77%,而中位数提升是3.92%,其分布如下︰

上面的分布与有着平均值3.77%的正态分布十分相似,大部分的效应(58%)在-3%和+10%之间。可以看到,在数据修剪后大部分的极端高的结果都被移除,在最初的数据集中有8个效应大于35%。这是因为在极端早的结果中,测试往往是在数据窥探、极端大的提升下就被早早停止。自然而然,这些结果也有着极端的不确定性。

大部分效应在10%提升以下的这一事实进一步支持大部分测试的检定力低下的论点,因为在115个测试中只有24个测试在90%检定力和95%显著度下,有着小于10%的最小可检定效应。

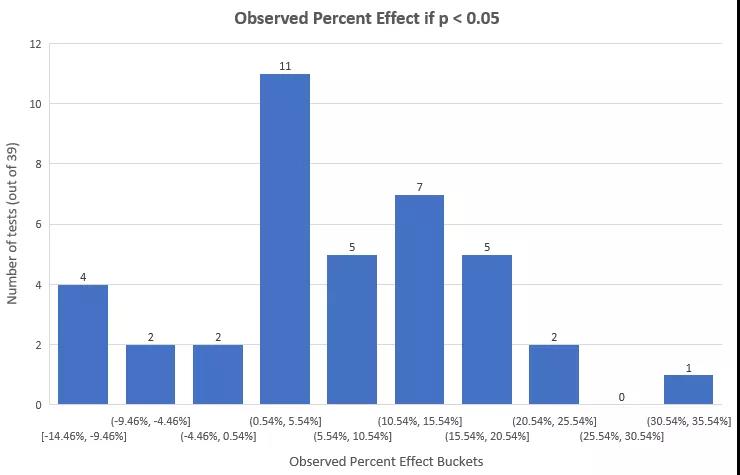

统计上显著(p<0.05)的测试的观察效应大小为︰

大部分测试的结果都落在0.54%-5.54%这一区间,而主体结果则在0.54%和20.54%之间。对于统计上显著的测试,它们的观察效应大小的算术平均值为6.78%的提升,当中50%的测试结果少于5.96%,而这些来自统计上显著的结果的效应大小自然地相较整体来得大。

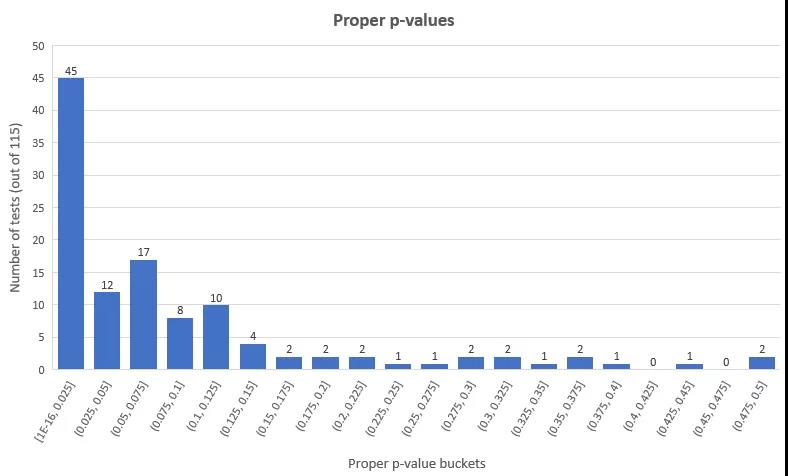

85个测试的p值分布如下︰

可以看到在85个测试中,只有39个(45.88%)有统计上显著的结果,当中8个是负值结果,大部分测试(20个)的p值落在0.05-0.1的范围。

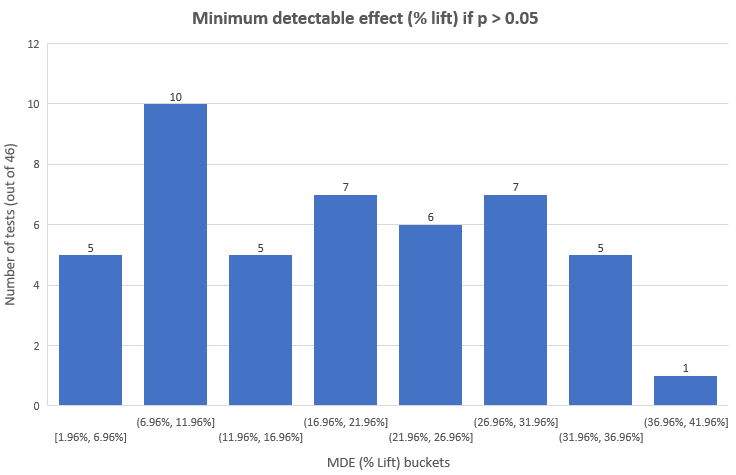

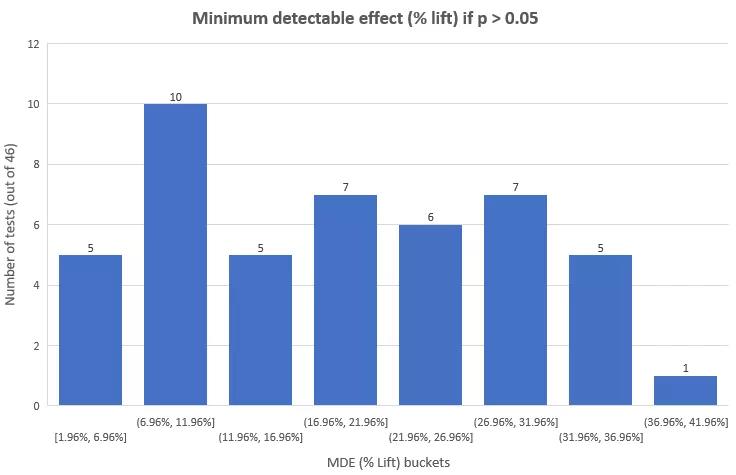

当有这么一大部分的测试没有达到常用的显著度阈值时,不禁令人怀疑当中出现了什么问题。直接把它们视作无价值的测试而丢弃显然不是个好做法。一般来说,我们会通过观察检定力和最小可检测效应进行分析,以下是85个测试的最小可检测效应的分布︰

然后是在0.05阈值下不显著的测试的分布︰

我们可以看到只有46个不显著测试中的15个(32.6%)有着低于12%的最小可检测效应。对于这些测试我们可以把有着90%可能性的12%或更大的效应大小排除掉。但对于余下的25个测试,因为它们的最小可检测效应非常大,以至于对它们的排除并不会带来新的情报︰这些测试的干预程度使得如此大的效应变得几近不可能出现。

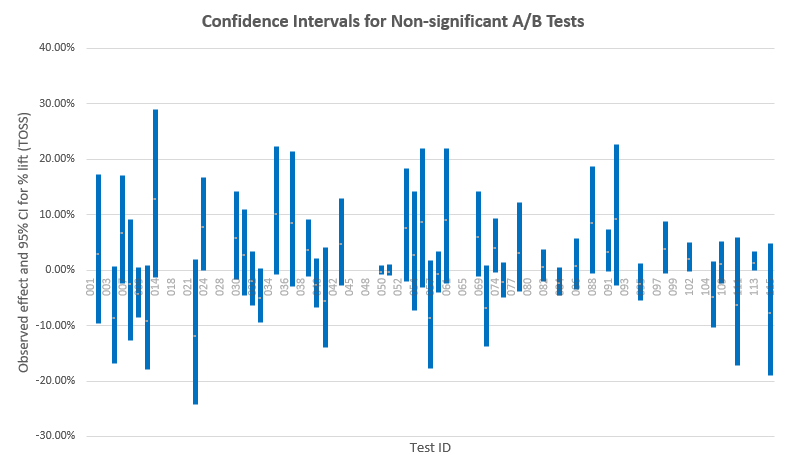

另一个更加直觉地评估没有被排除的效应大小(被置信区间覆盖的效应大小)的方法是观察置信区间︰

有一部分的测试有着围绕零点的狭窄区间,它们都是检定力良好的测试。当中几个更是正相等测试,即在这些测试中变量和对照之间很大机率没有任何差异。GoodUI并没有很好地利用这一点,而是粗略地把它们定义为”不显著”,而失去了能从这些数据中获取信息的机会。

留意有着负值观察结果的测试实际上也覆盖了大程度的正值效应,反之亦然,这些都是检定力低下的测试。一般来说,区间越宽,测试的检定力就越低下。

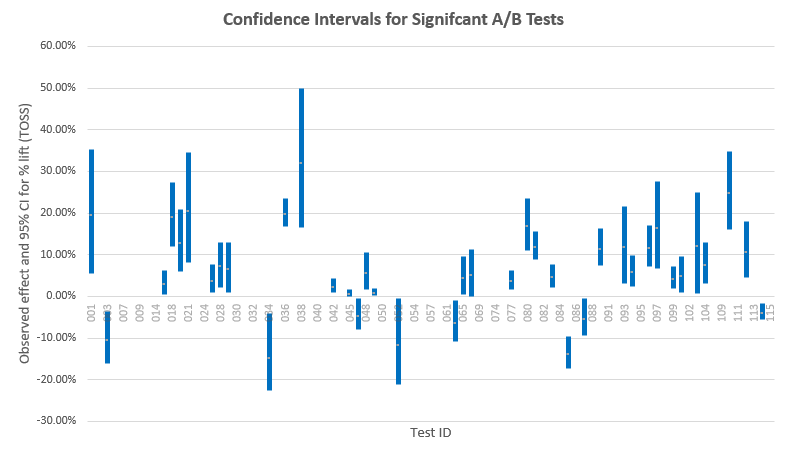

现在让我们检视一下统计上显著的测试的置信区间,从中我们能了解观察效应大小和真实效应大小的接近程度︰

我们可以看到绝大部分测试几乎没有排除到0%附近的区域,很多区间只坐落在0%附近的几个百分点。如果笔者关于数据窥探的怀疑是正确的,那么这些测试的结果则相当有问题。某些区间颇为远离0%,说明它们的数据很大机会反映了实际情况中会出现很大程度的差异。

同样地我们能看到比较狭窄的区间来自检定力高的测试,而比较阔宽的区间则来自检定力低下的测试。举个例子,测试#36和#38都有着高于16%提升的下界,但测试#38的信赖区间较为阔宽,显出它是检定力低下的,而下界远离0%的原因来自较大的观察效应大小(也非常有可能是真实效应大小)。当然,以上假设的前提是测试中没有出现数据窥探和其他统计上的滥用问题。

讨论和重点

在115个测试中只有31个有着统计上显著的正值结果(在数据修剪后),这比起其他行业报告中如10%或5%的低数值来得要高。显著性结果的缺失部分是由于大约70%的测试经过分析都没有很好的检定力,另一方面则是因为测试中的干预不够有效,又或者没有造成明显的负值效应。而在考虑这些数字是否能代表行业情况时,也要考虑报导/出版的偏差。

关于统计上显著的正值测试,它们的平均百分比改变为10.73%(中位数7.91%)。这一结果在测试时长方面部分受挫于统计上显著的负值测试,原因是显著测试的平均值是6.78%(中位数5.96%),而全部测试小于4%(平均值3.77%,中位数3.92%)。笔者相信即使这一数据缺失了其代表性,它仍能帮助告知决策者有关转换率最优化程序的可能结果,笔者也相信它能在从业者决定是否把最小可检定效应放到检定力和样本大小计算中时起到帮助作用。笔者在做出这些决定时全凭每个独立A/B测试的水平,同时考虑到全部成本和回报,但外部基准在评估与测试有关的风险和回报时绝对有帮助。

而在研究测试时也有机会忽略有关在任何显著大小下的效应缺失的有力数据,原因在于相关测试被标签为”不显著”。

因为在元分析中的样本并不具代表性,所以得出的结果在用途上会有一定限制。另一个值得考虑的问题是测试有着不同的主要输出︰有的关注于改变轻微的点击行为,有的关注于改善试验注册,购买率,等等。

在报告中的测试没有一个以收入作为主要KPI的,而当中最少一个测试(#24)的主要输出与以收入为基本的KPI有着直接分歧(测试的成功有可能损害到中期和长期的收入)。还有一个问题是缺乏有关测试中用到的停止准则的信息︰如果以上提及的假设是正确的,而且有70%或更多的测试没有被正确地实行,那么一大部分的测试结果有可能是带有偏差的,且偏向任一方向的显著结果。

就A/B测试的收集和报告而言,笔者认为重点相当明显︰确保适当地计算统计量,而前提是需要知道测试在统计上是怎样设计的。需要知道测试是固定样本还是连续观察的设计,如果是连续观察的设计,那么分析的数目和时间又是多少。需要知道测试的变量数,又在人流分配中有没有任何值得怀疑的地方等等。这些都已经在之前的文章或者其他地方中讨论过。

原文标题︰

Analysis of 115 A/B Tests: Average Lift is 4%, Most Lack Statistical Power

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。